简介

Portkey 通过提供以下生产就绪功能,增强 CrewAI,将您的实验性代理团队转变为强大的系统:- 对每个代理步骤、工具使用和交互的完整可观测性

- 内置可靠性,包括故障转移、重试和负载均衡

- 成本跟踪和优化,以管理您的 AI 开销

- 通过单一集成访问 200 多个 LLM

- 防护栏,确保代理行为安全合规

- 版本控制的提示,以实现一致的代理性能

安装和设置

1

安装所需的包

生成 API 密钥

从 Portkey 控制面板创建 Portkey API 密钥,可选择添加预算/速率限制。您还可以将可靠性、缓存等配置附加到此密钥。稍后将详细介绍。

3

使用 Portkey 配置 CrewAI

集成很简单——您只需更新 CrewAI 设置中的 LLM 配置

什么是虚拟密钥?Portkey 中的虚拟密钥将您的 LLM 提供商 API 密钥(OpenAI、Anthropic 等)安全地存储在加密保险库中。它们允许更简单的密钥轮换和预算管理。在此处了解有关虚拟密钥的更多信息。

生产功能

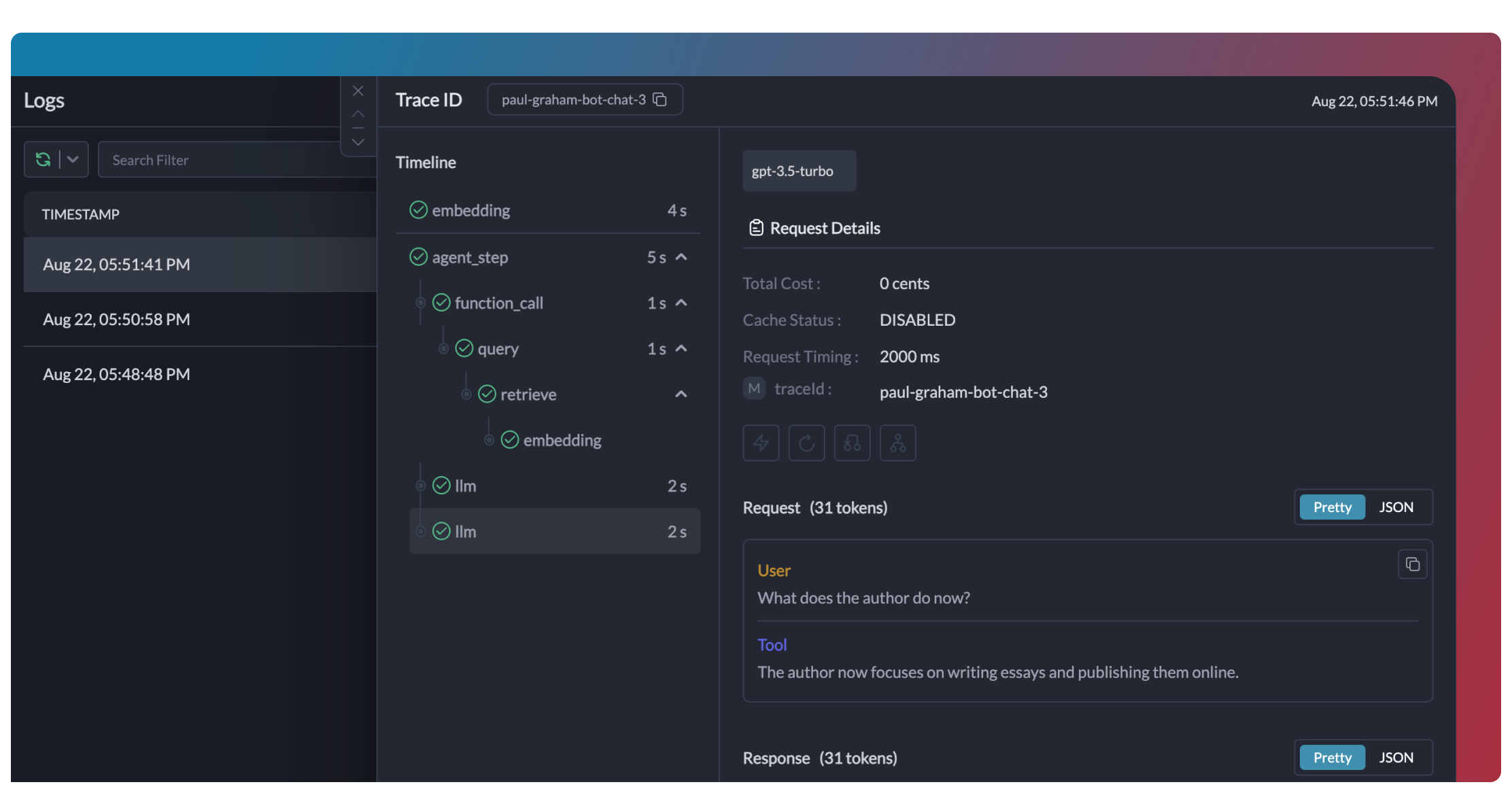

1. 增强的可观测性

Portkey 为您的 CrewAI 代理提供全面的可观测性,帮助您准确了解每次执行过程中发生的情况。- 追踪

- 日志

- 指标和仪表盘

- 元数据过滤

2. 可靠性 - 确保您的团队顺利运行

在生产中运行团队时,可能会出现问题——API 速率限制、网络问题或提供商中断。Portkey 的可靠性功能可确保您的代理即使在出现问题时也能顺利运行。通过使用 Portkey 配置,在 CrewAI 设置中启用故障转移很简单:自动重试

自动处理临时故障。如果 LLM 调用失败,Portkey 将按指定次数重试相同的请求——非常适合速率限制或网络瞬断。

请求超时

防止您的代理挂起。设置超时以确保您在所需的时间范围内获得响应(或可以优雅地失败)。

条件路由

将不同的请求发送给不同的提供商。根据您的需求,将复杂的推理路由到 GPT-4,将创意任务路由到 Claude,将快速响应路由到 Gemini。

故障转移

即使您的主要提供商失败,也能保持运行。自动切换到备用提供商以保持可用性。

负载均衡

将请求分散到多个 API 密钥或提供商。非常适合高流量团队操作和保持在速率限制内。

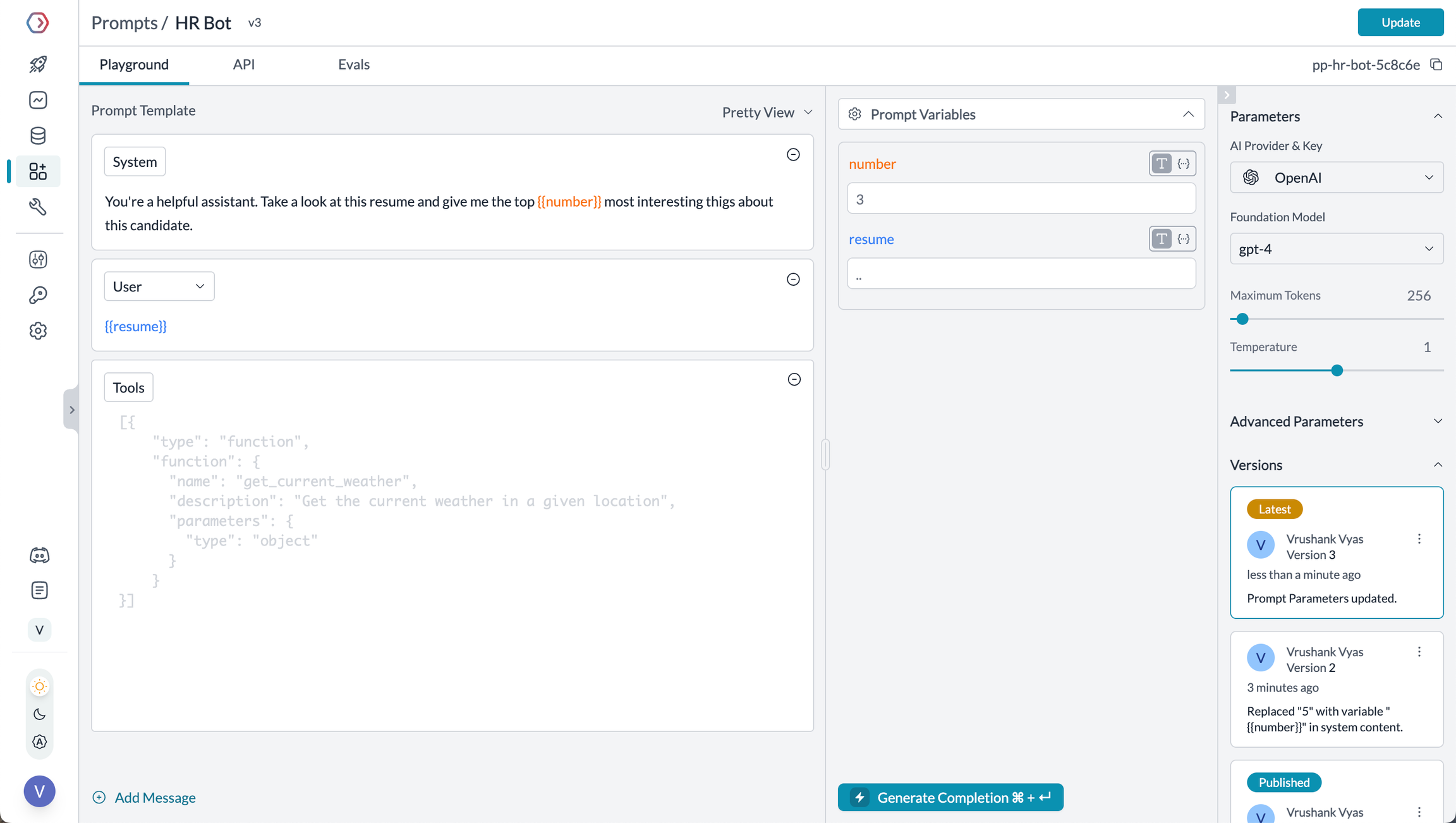

3. CrewAI 中的提示

Portkey 的提示工程工作室可帮助您创建、管理和优化 CrewAI 代理中使用的提示。您可以使用 Portkey 的提示渲染 API 动态获取和应用版本化提示,而不是硬编码提示或指令。

在 Portkey 的提示库中管理提示

- 提示游乐场

- 使用提示模板

- 提示版本控制

- 变量的 Mustache 模板

提示游乐场是比较、测试和部署完美提示以供您的 AI 应用程序使用的地方。您可以在部署到生产环境之前,在这里试验不同的模型、测试变量、比较输出并完善您的提示工程策略。它允许您:

- 在使用代理之前迭代开发提示

- 使用不同的变量和模型测试提示

- 比较不同提示版本之间的输出

- 与团队成员协作进行提示开发

提示工程工作室

了解有关 Portkey 提示管理功能的更多信息

4. 安全团队的防护栏

防护栏可确保您的 CrewAI 代理安全运行并在所有情况下做出适当响应。为什么要使用防护栏?CrewAI 代理可能会遇到各种故障模式:- 生成有害或不当内容

- 泄露 PII 等敏感信息

- 产生错误信息

- 生成格式不正确的输出

- 检测并编辑输入和输出中的 PII

- 过滤有害或不当内容

- 根据 Schema 验证响应格式

- 对照事实真相检查幻觉

- 应用自定义业务逻辑和规则

了解有关防护栏的更多信息

探索 Portkey 的防护栏功能,以增强代理安全性

5. 使用元数据进行用户跟踪

使用 Portkey 的元数据系统通过 CrewAI 代理跟踪单个用户。Portkey 中的元数据是什么?元数据允许您将自定义数据与每个请求关联起来,从而实现过滤、分段和分析。特殊的_user 字段专为用户跟踪而设计。

按用户筛选分析

- 按用户成本跟踪和预算

- 个性化用户分析

- 团队或组织级别的指标

- 特定环境监控(暂存与生产)

了解有关元数据的更多信息

探索如何使用自定义元数据来增强您的分析

6. 缓存以提高团队效率

实施缓存以提高 CrewAI 代理的效率和成本效益- 简单缓存

- 语义缓存

7. 模型互操作性

CrewAI 支持多个 LLM 提供商,Portkey 通过统一接口提供对 200 多个 LLM 的访问,从而扩展了此功能。您可以在不更改核心代理逻辑的情况下轻松切换不同的模型- OpenAI (GPT-4o, GPT-4 Turbo 等)

- Anthropic (Claude 3.5 Sonnet, Claude 3 Opus 等)

- Mistral AI (Mistral Large, Mistral Medium 等)

- Google Vertex AI (Gemini 1.5 Pro 等)

- Cohere (Command, Command-R 等)

- AWS Bedrock (Claude, Titan 等)

- 本地/私有模型

支持的提供商

查看 Portkey 支持的 LLM 提供商完整列表

为 CrewAI 设置企业治理

为什么要进行企业治理?如果您在组织内部使用 CrewAI,则需要考虑几个治理方面:- 成本管理:控制和跟踪跨团队的 AI 开支

- 访问控制:管理哪些团队可以使用特定模型

- 使用分析:了解 AI 在整个组织中的使用方式

- 安全与合规:维护企业安全标准

- 可靠性:确保所有用户获得一致的服务

1

创建虚拟密钥

虚拟密钥是 Portkey 管理您的 LLM 提供商 API 密钥的安全方式。它们提供必要的控制,例如:

- API 使用的预算限制

- 速率限制功能

- 安全的 API 密钥存储

保存您的虚拟密钥 ID——下一步会用到。

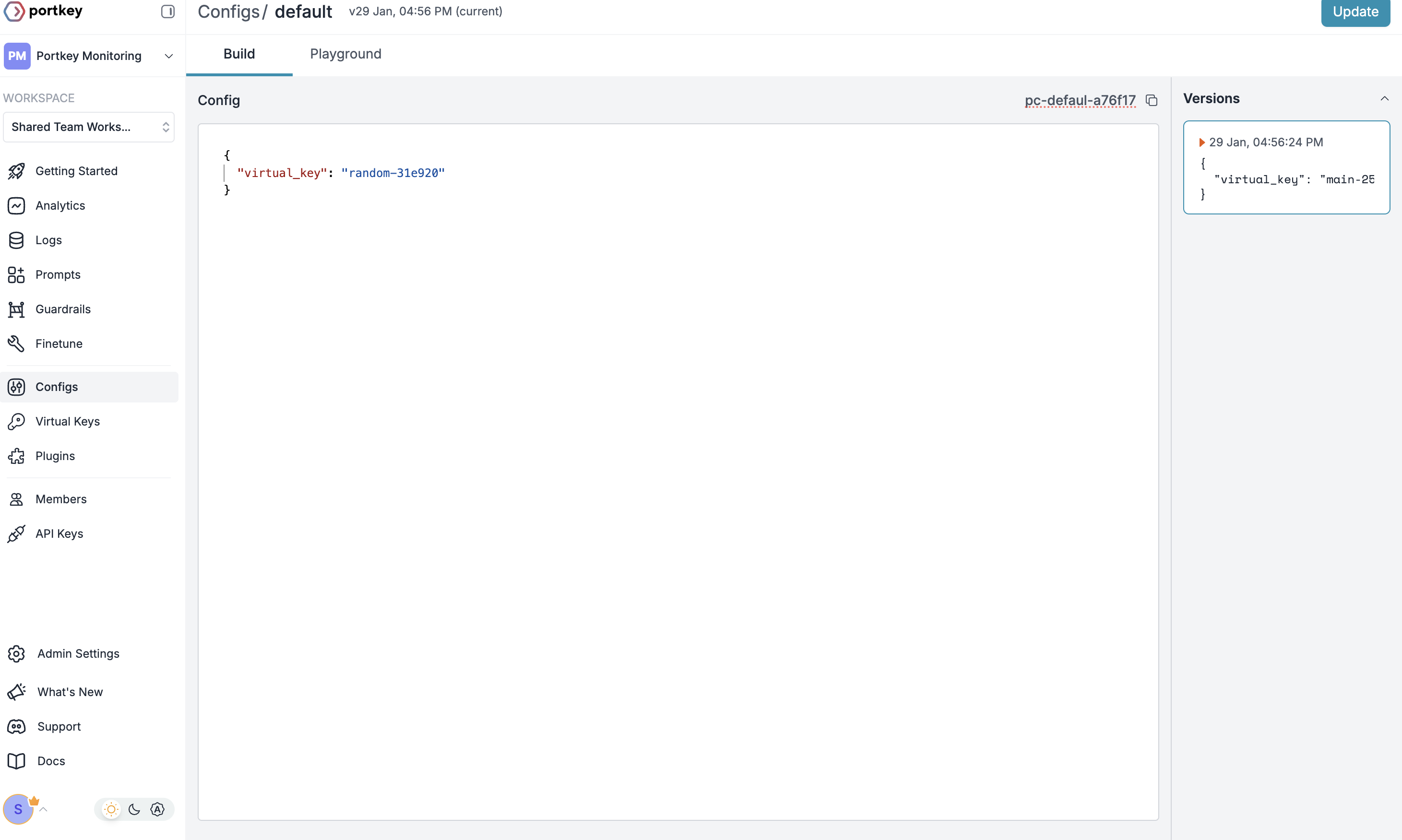

2

创建默认配置

3

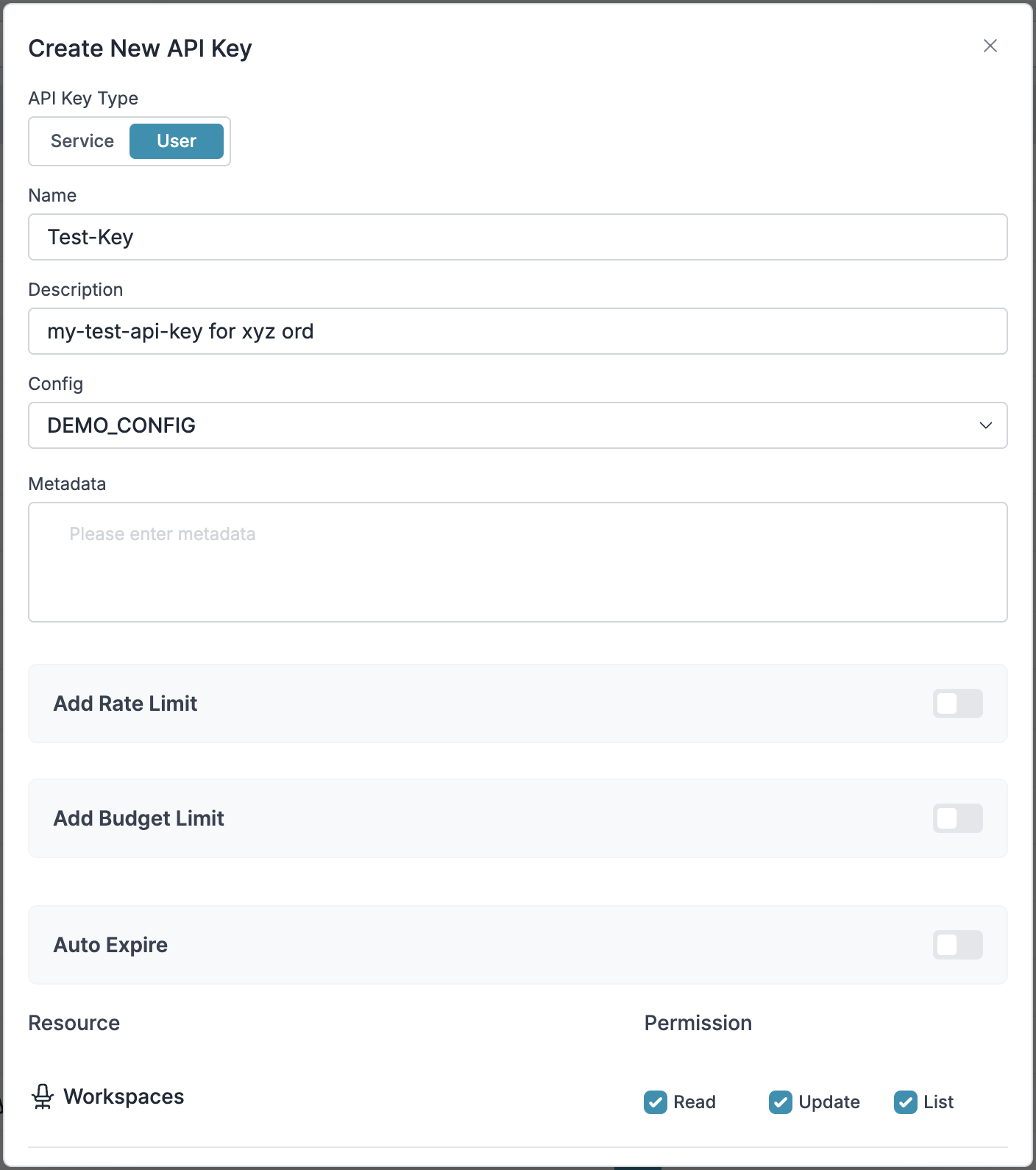

配置 Portkey API 密钥

4

连接到 CrewAI

设置好带有所附配置的 Portkey API 密钥后,将其连接到您的 CrewAI 代理

步骤 1:实施预算控制和速率限制

步骤 1:实施预算控制和速率限制

步骤 2:定义模型访问规则

步骤 2:定义模型访问规则

步骤 3:实施访问控制

步骤 3:实施访问控制

步骤 3:实施访问控制

创建用户专用 API 密钥,自动- 借助虚拟密钥跟踪每个用户/团队的使用情况

- 应用适当的配置以路由请求

- 收集相关元数据以过滤日志

- 强制执行访问权限

步骤 4:部署和监控

步骤 4:部署和监控

步骤 4:部署和监控

在将 API 密钥分发给您的团队成员后,您的企业就绪型 CrewAI 设置即可投入使用。现在,每个团队成员都可以使用其指定的 API 密钥,并具有适当的访问级别和预算控制。在 Portkey 控制面板中监控使用情况:- 按部门划分的成本跟踪

- 模型使用模式

- 请求量

- 错误率

常见问题

Portkey 如何增强 CrewAI?

Portkey 如何增强 CrewAI?

Portkey 通过全面的可观测性(追踪、日志、指标)、可靠性功能(故障转移、重试、缓存)和通过统一接口访问 200 多个 LLM,为 CrewAI 增加了生产就绪性。这使得调试、优化和扩展您的代理应用程序变得更容易。

我可以使用 Portkey 与现有的 CrewAI 应用程序吗?

我可以使用 Portkey 与现有的 CrewAI 应用程序吗?

是的!Portkey 可与现有 CrewAI 应用程序无缝集成。您只需使用启用 Portkey 的版本更新您的 LLM 配置代码。其余的代理和团队代码保持不变。

Portkey 适用于所有 CrewAI 功能吗?

Portkey 适用于所有 CrewAI 功能吗?

Portkey 支持所有 CrewAI 功能,包括代理、工具、人机交互工作流以及所有任务处理类型(顺序、层次结构等)。它增加了可观测性和可靠性,而不限制框架的任何功能。

我可以在一个团队中的多个代理之间跟踪使用情况吗?

我可以在一个团队中的多个代理之间跟踪使用情况吗?

是的,Portkey 允许您在团队中的多个代理之间使用一致的

trace_id 来跟踪整个工作流。这对于复杂的团队特别有用,您希望了解跨多个代理的完整执行路径。我如何过滤特定团队运行的日志和追踪?

我如何过滤特定团队运行的日志和追踪?

Portkey 允许您向 LLM 配置添加自定义元数据,然后您可以使用这些元数据进行过滤。添加

crew_name、crew_type 或 session_id 等字段,可以轻松查找和分析特定的团队执行。我可以使用自己的 API 密钥与 Portkey 吗?

我可以使用自己的 API 密钥与 Portkey 吗?

是的!Portkey 使用您自己的各种 LLM 提供商的 API 密钥。它将它们安全地存储为虚拟密钥,让您可以轻松管理和轮换密钥,而无需更改代码。